第一章、人工智慧之道

目前生成式 AI (如 ChatGPT) 回答的結果不可預期,很可能發生「隨機回應」的困擾。

雖然在一般「Chat」聊天性質有不錯的結果,

但目前應該還不適合應用在需要有正確答案的環境,

尤其是醫療領域,即使正確率高達 90%,但 10% 的錯誤造成的衝擊可能會很大。即使是一般企業也有一定的風險,

當新人在沒有足夠的背景、經驗和敏銳度下,

幾乎無法判斷 AI 是不是一本正經的胡說八道。

一旦乍聽之下有道理,

通常就不會主動問 (因為看不出問題),照著做很可能就會造成嚴重的問題。

實際案例,

可以參考:「AI 幻覺 (hallucination) 的風險」

要得到具參考價值的回應,很依賴「提問引導」的技巧,

根據統計,有溝通落差 (雞同鴨講) 的人高達 90% 以上,

這問題雖然可以從不斷的對話當中逐漸釐清,但需要有經驗、智慧的「人類」引導效果比較好。

接下來,我們就以護理衛教的應用為例,來展示目前的 AI 技術可能會帶來的問題。

1. 實驗方法

請 ChatGPT 根據特定資料來回應,資料來源:

以下是在 2024年6月和 ChatGPT 對談的內容

我:

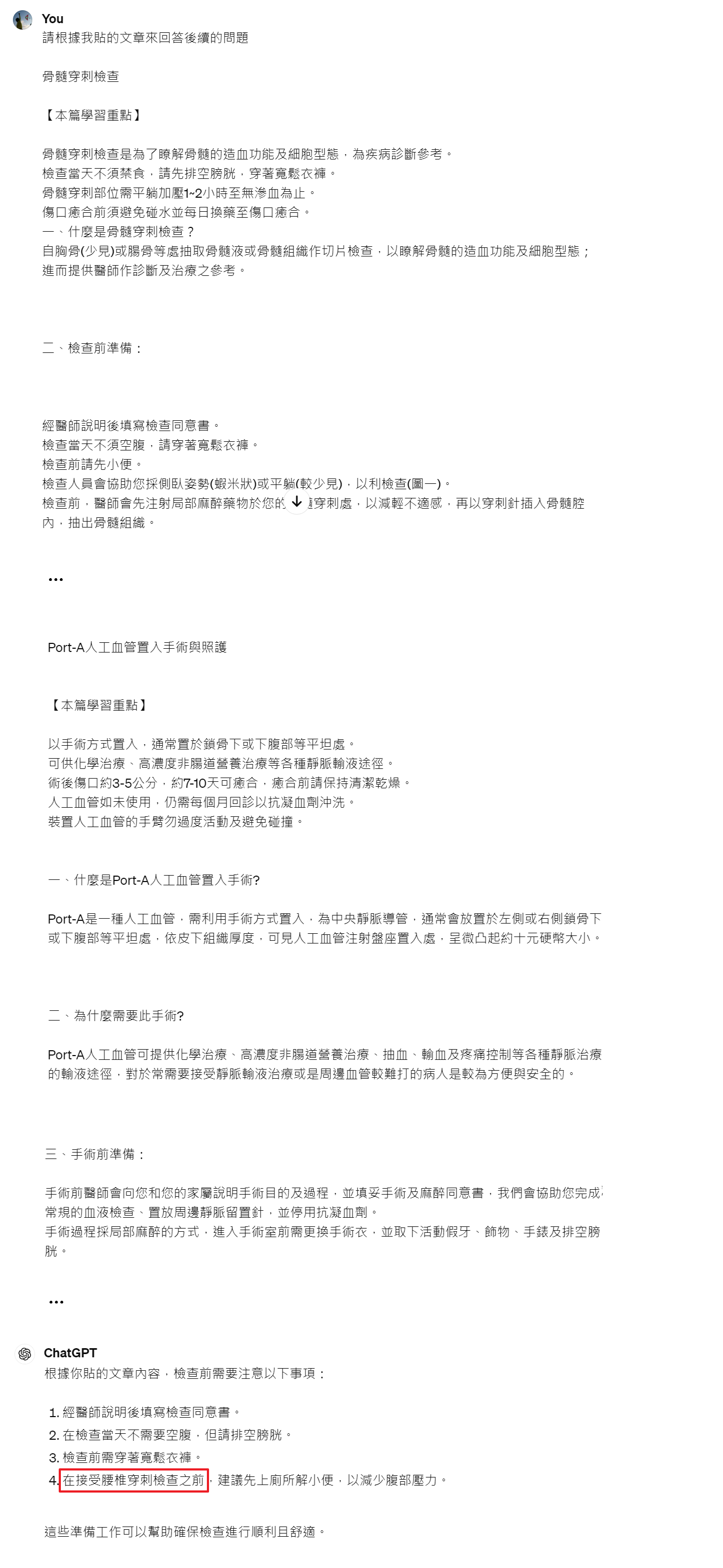

請根據我貼的文章來回答後續的問題 (貼上述的護理衛教內容,圖2)

ChatGPT:

根據你貼的文章內容,檢查前需要注意以下事項: ... (隨機回應,直接取「腰椎穿刺」,但內容有「骨髓穿刺」、「腰間穿刺」兩種,圖2)

我:

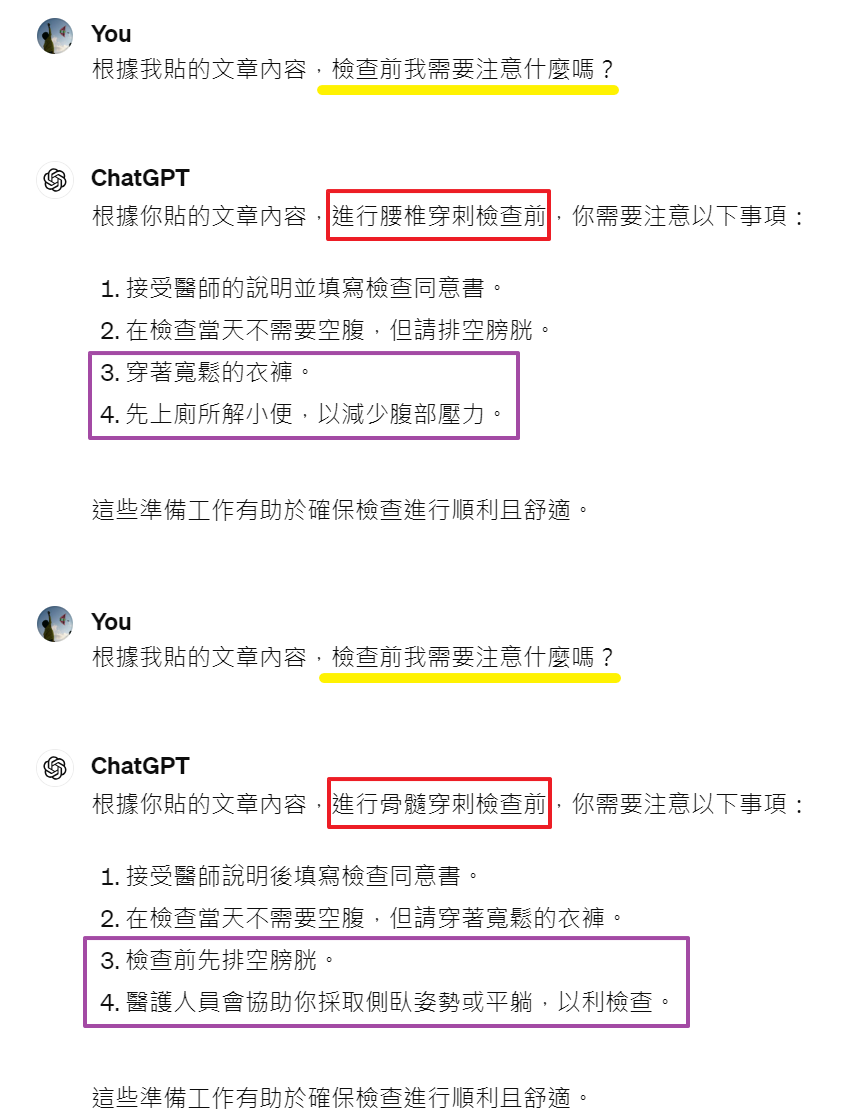

根據我貼的文章內容,檢查前我需要注意什麼嗎? (連續問 2 次同樣的問題,圖1)

ChatGPT:

同樣的問題,兩次得到不同的答案 (圖1)

這是因為生成式 AI 的本質可以看成是利用超大型的類神經網路 (數千億個參數),計算出機率分布來進行「文字接龍」,因此每次的輸出可能會不一樣。我所依據的知識庫中有「骨髓、腰間」兩種穿刺檢查,請問您想問的是哪一種呢?

(類似人類的互動引導,截至目前 (2024) 生成式的 AI 技術還做不好,雖然過兩年應該就可以克服,但還是有其他問題就是了)

2. 應用情境分析

以下分析上述對話的合理性與可能的後續影響

- 問法合理

在特定背景下 (病人知道要做骨髓穿刺),因此問「檢查前要注意什麼?」是合理的。

因為很少人會精準、完整的提問。 - 回應正確

雖然 ChatGPT 有回應「腰間穿刺」的檢查,但病人可能沒有注意到,在資訊爆炸時代,大家看內容比較不仔細。 - 結果錯誤

病人依據誤解的檢查建議,導致醫學檢查結果偏誤,甚至可能影響治療方法,造成不可預期的後果。

圖1: 同樣的問題,不同的答案

圖2: 隨機回應,直接取「腰椎穿刺」,但內容有「骨髓、腰間」兩種穿刺

評語

請登入後才可以評分

未登入或權限不足!

- 位置

-

- 資料夾名稱

- 人工智慧之道 ~ 打造不會胡說八道的 AI 知識庫

- 上傳者

- 蘇德宙

- 單位

- 台灣數位員工

- 建立

- 2025-02-05 11:34:42

- 制訂日期

- 2024-06-02

- 最近修訂

- 2025-07-07 13:19:40

- 引用

- 1